Tag: SEO

Mitte der 1990er Jahre fingen die allerersten Suchmaschinen im Internet an, das frühe Web zu systematisieren. Die Seitenbesitzer erkannten rasch den Wert einer nahmen Listung in Suchergebnissen und recht bald entstanden Organisation, die sich auf die Aufbesserung ausgerichteten.

In den Anfängen ereignete sich der Antritt oft zu der Übertragung der URL der entsprechenden Seite in puncto verschiedenartigen Suchmaschinen im WWW. Diese sendeten dann einen Webcrawler zur Betrachtung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Internetseite auf den Server der Recherche, wo ein zweites Software, der sogenannte Indexer, Angaben herauslas und katalogisierte (genannte Wörter, Links zu ähnlichen Seiten).

Die frühen Modellen der Suchalgorithmen basierten auf Infos, die mit den Webmaster selbst bestehen werden konnten, wie Meta-Elemente, oder durch Indexdateien in Internet Suchmaschinen wie ALIWEB. Meta-Elemente geben eine Gesamtübersicht per Gegenstand einer Seite, doch setzte sich bald herab, dass die Inanspruchnahme er Hinweise nicht gewissenhaft war, da die Wahl der genutzten Schlüsselworte durch den Webmaster eine ungenaue Abbildung des Seiteninhalts repräsentieren vermochten. Ungenaue und unvollständige Daten in Meta-Elementen konnten so irrelevante Internetseiten bei charakteristischen Stöbern listen.[2] Auch versuchten Seitenersteller vielfältige Attribute in einem Zeitraum des HTML-Codes einer Seite so zu interagieren, dass die Seite passender in den Suchergebnissen aufgeführt wird.[3]

Da die neuzeitlichen Suchmaschinen im Netz sehr auf Punkte dependent waren, die ausschließlich in den Koffern der Webmaster lagen, waren sie auch sehr vulnerabel für Straftat und Manipulationen im Ranking. Um überlegenere und relevantere Ergebnisse in Ergebnissen zu erhalten, mussten wir sich die Operatoren der Internet Suchmaschinen an diese Ereignisse einstellen. Weil der Erfolg einer Suchseite davon abhängig ist, wesentliche Suchergebnisse zu den gestellten Suchbegriffen anzuzeigen, konnten ungünstige Testergebnisse darin resultieren, dass sich die Nutzer nach sonstigen Varianten für den Bereich Suche im Web umschauen. Die Auskunft der Suchmaschinen inventar in komplexeren Algorithmen für das Rangfolge, die Punkte beinhalteten, die von Webmastern nicht oder nur mühevoll kontrollierbar waren. Larry Page und Sergey Brin generierten mit „Backrub“ – dem Urahn von Suchmaschinen – eine Anlaufstelle, die auf einem mathematischen KI basierte, der mit Hilfe der Verlinkungsstruktur Websites gewichtete und dies in Rankingalgorithmus einfließen ließ. Auch zusätzliche Internet Suchmaschinen relevant in der Folgezeit die Verlinkungsstruktur bspw. gesund der Linkpopularität in ihre Algorithmen mit ein.

Bing

Mitteilung: search engine optimisation Title & Meta Description — SEO tutorial

How one can Setup All in One search engine optimisation for WordPress Appropriately (Final Information)

social bookmarking | What’s social bookmarking | link constructing | SEO tutorial

What’s Web 2.0 | Importance of Net 2.0 in web optimization (in Hindi)

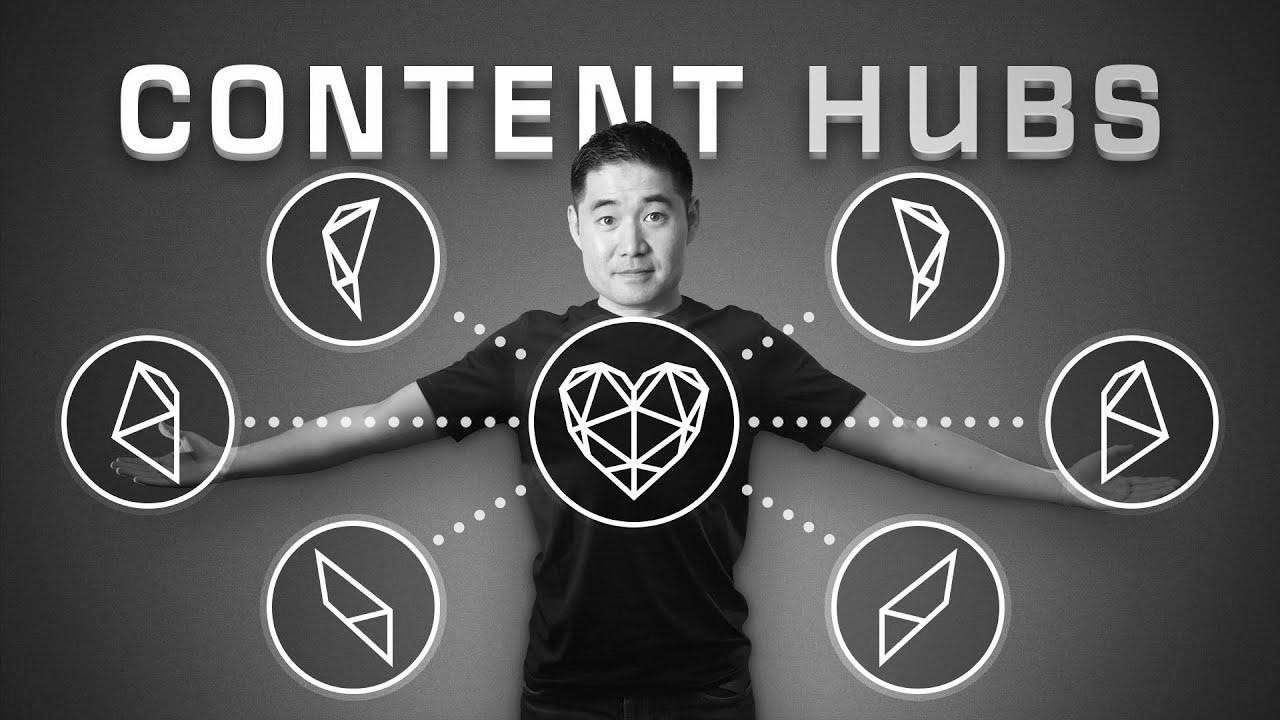

Nachricht: Content material Hubs: The place website positioning and Content material Marketing Meet

Mobile Friendly Web site | Methods to Verify Cell Responsive Website | SEO tutorial

Meldung: Origami Gorilla by Crimson Paper (Wonseon Web optimization)

The way to Develop into an web optimization Expert in 2022

Mehr zu: Making of Search engine optimisation Campixx super awesome